Robots.txt、Sitemap 和 Canonical 标签 如何协同工作

内容是王,但结构是道。无论你的文章多么优秀,如果 Google 无法高效抓取、识别并正确索引这些内容,就无法获得应有的排名与曝光。

在上一篇文章中,我们已经明确了高质量内容的 E-E-A-T 标准。现在,你需要做的是确保 Google 的爬虫在你的网站里“顺利通关”,不浪费爬虫预算(Crawl Budget),不迷路,不重复抓取,也不会抓到不该访问的页面。

正确配置 Robots.txt、XML Sitemap 与 Canonical 标签,就是技术 SEO 的三大支柱,也是避免重复内容、最大化抓取效率、提升搜索排名的关键基础。

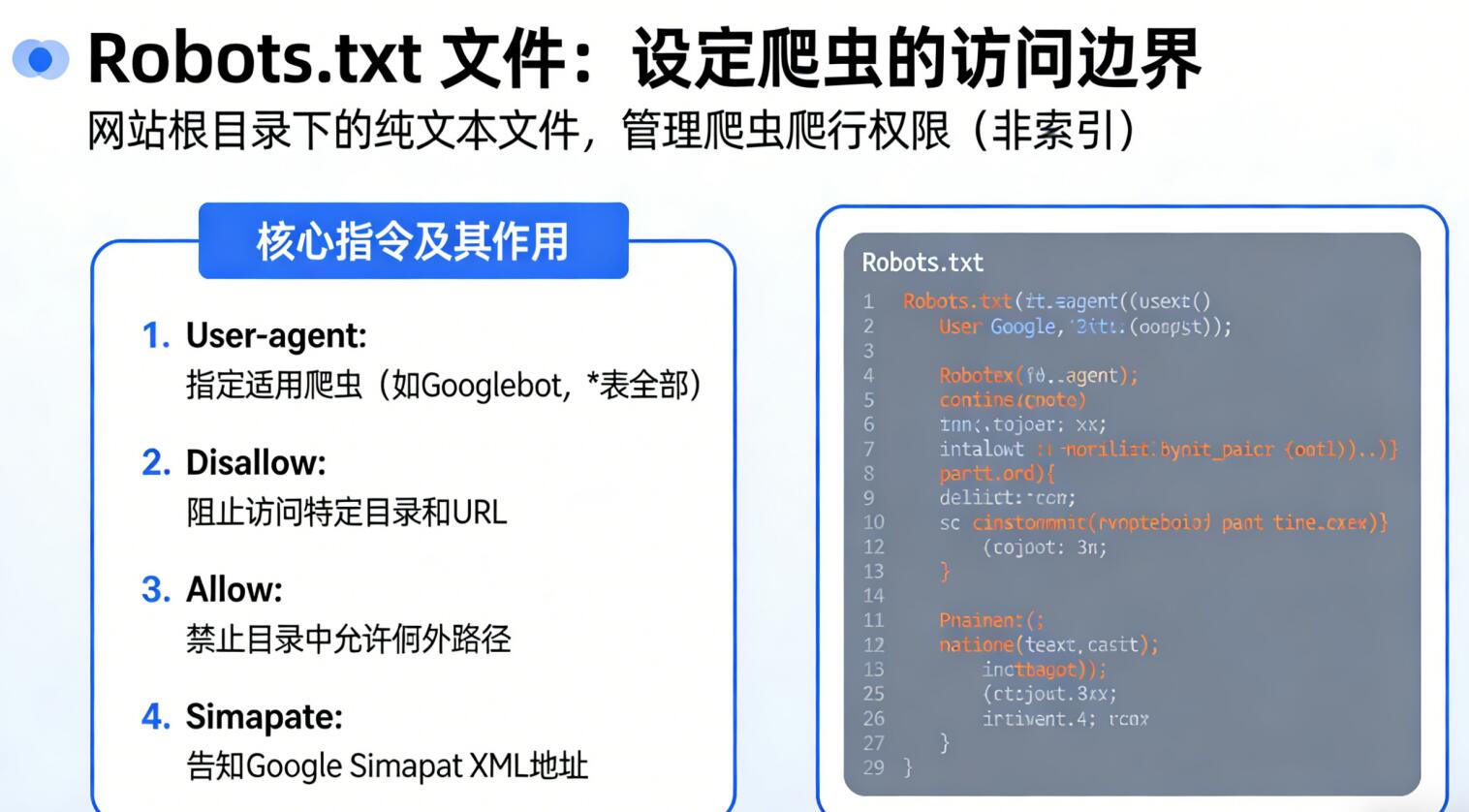

1. Robots.txt 文件:设定爬虫的访问边界

Robots.txt 是放置在网站根目录下的纯文本文件,它告诉用户代理(爬虫)哪些页面可以访问、哪些页面禁止访问。它是整个网站的“爬虫指挥台”,管理的对象是爬行(Crawling),而并非索引(Indexing)。

1.1 核心指令及其作用

- User-agent: 指定规则适用的爬虫,如 Googlebot;`*` 代表全部爬虫。

- Disallow: 阻止爬虫访问特定目录或 URL。

- Allow: 在被禁止的目录中,允许访问某些例外路径。

- Sitemap: 告诉 Google 你的 Sitemap XML 地址。

1.2 Robots.txt 最佳实践

- 阻止非必要页面: 如后台管理页、测试目录、预览页面等,能节省爬虫预算。

- 不要用 Robots.txt 隐藏敏感内容: 如果你不希望页面被索引,应该使用

noindex,而非 Disallow。 - 不要阻止 CSS / JS 文件: Google 需要读取这些文件来理解用户体验与布局。

- 避免宽泛屏蔽: 例如

Disallow: /wp-*很可能会错误阻止资源。 - 每次修改后使用 Google Search Console 测试: 确保无误。

2. XML Sitemap:确保所有重要页面被发现

XML Sitemap 就像网站的“地图”。Google 可以不依赖内部链接,而直接从 Sitemap 获取你希望被抓取与索引的页面。它不影响排名,但极大提升索引效率,尤其适用于大型网站、结构复杂的网站或新站。

2.1 Sitemap 的价值与最佳配置

- 快速发现新页面: 尤其是“孤儿页面”(无内部链接)。

- 包含规范 URL: 仅包含 canonical 版本,不要包含重定向或重复 URL。

- 分割大型 Sitemap: 每个文件最多 5 万 URL,超过需使用 Sitemap Index。

- 支持多媒体: 图片、视频、新闻内容可使用专门 Sitemap。

提交建议: 1) 在 Google Search Console 中手动提交 Sitemap 2) 在 Robots.txt 中引用 Sitemap 路径 这两者缺一不可。

一个优秀的 XML Sitemap,本质上是“告诉 Google:这是我最重要的页面,请优先抓取、优先索引”。

3. Canonical 标签:重复内容的终极解决方案

重复内容(Duplicate Content)会导致排名信号分散,影响 PageRank 传递,也会让 Google 难以判断哪个版本才应被优先索引。从而导致排名下滑或页面被忽略。

Canonical 标签告诉 Google: “众多版本中,这个 URL 才是主版本(Preferred Version)。”

3.1 必须使用 Canonical 标签的场景

- URL 参数: 如筛选器、分页、追踪参数产生大量重复内容。

- 跨协议、跨域: http 与 https、www 与非 www 都必须统一为标准 URL。

- 分页系列: 多页文章可指定第一页或“查看全部”页为主版本。

- 内容 syndication: 授权文章被转载时必须要求对方添加 canonical 指向原文。

3.2 Canonical 最佳实践

- 自我 canonical: 必须在每一个页面设置 canonical 至自身。

- 避免链式 canonical: A → B → C 属于错误用法,会使 Google 忽视你的设置。

- Canonical 是建议而不是命令: Google 会评估你是否使用合理,不合理时会忽略。

- 与 301 重定向配合使用: 两者不冲突,应同时确保主版本一致性。

总结:技术配置是内容成功的加速器

Robots.txt 是“限制”爬虫的工具; Sitemap 是“引导”爬虫的地图; Canonical 标签则是“合并权重”的核心策略。

当这三项技术 SEO 基础全部正确配置后,你的高质量内容才能真正被 Google 效率抓取、正确理解和完整索引。它们不仅提升 Crawl Budget 利用率,还能最大化排名信号,让每一篇内容都充分发挥价值。

版权所有,转载时必须以链接形式注明作者和原始出处及本声明。